Come regoleremo le intelligenze artificiali?

I regolamenti UE, Giappone, Cina, USA. Con un focus speciale su quello giapponese, radicalmente utopistico

Lo sviluppo recente delle tecnologie di intelligenze artificiali sta forzando stati e organizzazioni internazionali a lavorare su tematiche che fino a poco tempo fa erano sotto traccia. E, naturalmente, a produrre regolamenti.

Anche se una tecnologia così potenzialmente dirompente meriterebbe, probabilmente, dei tentativi di governance globale, la storia recente dell’umanità ci ha mostrato quanto questo sia difficile. Così bisogna accontentarsi di analizzare le operazioni di regolamentazione in diverse parti del mondo.

In Europa

Abbiamo visto come si sta muovendo l’Unione Europea.

In sintesi, l’AI Act è un regolamento – ancora non in vigore – che mira a stabilire quali usi di queste tecnologie sono consentiti, quali proibiti e quali consentiti sotto determinate condizioni. L’idea, dal punto di vista del legal design, cioè della progettazione della legge, è quella di avere una norma che possa sopravvivere al tempo che passa e alla velocità con cui la tecnologia viene sviluppata e trova applicazioni.

Cosa succede altrove?

Intelligenze Artificiali: le regole negli USA

Le aziende che stanno portando avanti i progetti più importanti e strutturati e anche visibili sono proprio le grandi compagnie della Silicon Valley, quelle che esistevano già da tempo come Google e Meta e le neonate, come OpenAI.

L’amministrazione Biden ha aggiornato un piano nazionale di ricerca e sviluppo. E ha ottenuto, a luglio 2023, un impegno volontario da parte di Amazon, Anthropic, Google, Inflection, Meta, Microsoft e OpenAI a procedere verso uno sviluppo sicuro, protetto e trasparente della tecnologia IA. L’impegno si può leggere qui.

In buona sostanza, le sette aziende coinvolte dichiarano di attenersi alle indicazioni dell’accordo su base volontaria, in attesa di regole definitive (un po’ come avviene per l’introduzione dell’AI Act europeo, ma senza il medesimo corpus già pronto di regolamento) che saranno anche vincolanti.

I pilastri di questo impegno volontario sono: sicurezza, protezione e fiducia.

Sicurezza significa testare le macchine e valutarne i potenziali rischi biologici, di cybersecurity e sociali e rendere pubblici i risultati di tali valutazioni.

Protezione vuol dire salvaguardia dei loro modelli da minacce esterne o interne.

Fiducia implica garantire che la tecnologia non promuova pregiudizi e discriminazione, che garantisca la protezione della privacy e dei minori.

La cosa interessante da notare è che gli impegni che stanno prendendo queste aziende si applicano solo a «modelli generativi che superano l’attuale frontiera industriale».

Le aziende si impegnano a condividere con i governi locali e federale le informazioni a loro disposizione; a investire in misure di sicurezza cibernetica e a proteggere i modelli non ancora rilasciati da ingerenze esterne; a segnalare problemi e vulnerabilità e a invitare tutti a fare altrettanto.

Infine, le aziende si sono impegnate a sviluppare meccanismi che permetteranno alle persone di capire se un audio o visivo è generato da IA e a dedicare i propri sforzi a sviluppare tecnologie basate su intelligenze artificiali che possano risolvere sfide concrete e attuali (come la diagnosi precoce del cancro o il cambiamento climatico)

Le battaglie in corso negli USA fra privati riguardano soprattutto la questione del copyright: ci sono cause in corso. L’idea di fondo di queste cause, sostenuta non solo negli Stati Uniti, è questa: chi programma le macchine usa, per esempio, le immagini di artisti (o i testi di scrittori) per addestrare queste macchine. In questo modo viola il copyright.

Per il momento le cause non stanno andando come vorrebbero gli artisti, e intanto un giudice federale americano ha stabilito che le immagini generate da un’AI non possono essere soggette a copyright. Ma nessuno sa bene come andrà a finire questa storia e dobbiamo aspettarci altre valutazioni in futuro.

Una strada possibile è quella intrapresa dal Giappone

Intelligenze Artificiali generative in Giappone

Il Giappone ci interessa per una delle questioni più rilevanti di tutte, parlando di intelligenze artificiali generative: l’uso dei dati (foto, testo, musica) per addestrare macchine di intelligenza artificiale generativa, infatti, viene esplicitamente consentito. Anche se l’addestramento avviene con materiale protetto da copyright.

L’ispirazione di questo principio sta nel fatto che l’addestramento della macchina viene in qualche modo equiparato al modo in cui funziona l’ispirazione creativa umana. «I modelli di intelligenza artificiale», scrivono su Decyipt spiegando le ragioni di chi sostiene approcci simili a quello giapponese, «scansionano il web per catalogare le immagini ma non per copiarle, allo stesso modo in cui una persona deve guardare una serie di immagini di Pablo Picasso per identificare ciò che distingue un Picasso da altre opere. Gli stili non possono essere protetti da copyright. Le immagini prodotte da un’intelligenza artificiale non sono copie di opere d’arte originali e i dati erano pubblicamente disponibili per essere visti da persone o computer».

È molto interessante notare che il documento chiave dell’approccio giapponese si intitola Social Principles of Human-Centric AI: la centralità dell’essere umano è la chiave di tutto il lavoro, che ha le proprie radici in questo documento del 2019.

La filosofia di tutto l’approccio è basata su tre pilastri di visione della società futura:

dignità: una società che rispetta la dignità umana

varietà e inclusione: una società dove persone con origini diverse possono perseguire il proprio benessere

sostenibilità: una società sostenibile

Ci sono poi sette principi chiave per la regolamentazione delle intelligenze artificiali:

Il principio umano-centrico prevede che le intelligenze artificiali non violino i diritti fondamentali garantiti dalla Costituzione e dagli standard internazionali e che questa tecnologia sia sviluppata per espandere le capacità delle persone e permettere a tutti di perseguire il proprio benessere. È necessario introdurre meccanismi per l’educazione e la promozione dell’uso corretto dell’IA.

Il principio di educazione/literacy prevede che le persone vengano abilitate all’uso di queste macchine. Una delle parti più interessanti del documento recita: «In una società in cui l’IA sarà onnipresente, ci si aspetta che l’ambiente educativo cambi dallo stile di insegnamento unilaterale e uniforme attuale a uno che valorizzi gli interessi e le competenze individuali. […] la nostra società ha bisogno di un sistema educativo che permetta a chiunque di acquisire le basi dell’IA, della matematica e della scienza dei dati. Le persone avranno bisogno di imparare oltre i confini della letteratura e delle scienze. È necessario insegnare i limiti della sicurezza, delle tecnologie di intelligenza artificiale,atificiale, le caratteristiche di queste macchine e dei loro dati, inclusi i bias (pregiudizi), la possibilità di causarne, le questioni di equità, imparzialità e protezione della privacy.

Il principio di protezione della privacy è spiegato dal suo stesso nome: si tratta di tutelare la sfera privata e intima delle persone.

Il principio della garanzia della sicurezza richiede un equilibrio consapevole tra rischi e benefici.

Il principio della concorrenza equa prevede un approccio inclusivo e allargato alle intelligenze artificiali. «Anche se le risorse legate all’intelligenza artificiale sono concentrate in un paese specifico, non dobbiamo creare una società in cui la posizione dominante di quel Paese consenta raccolta ingiusta dei dati e violazione della sovranità. Anche se le risorse legate all’intelligenza artificiale sono concentrate in aziende specifiche, non dobbiamo avere una società in cui queste aziende sfruttino la loro posizione dominante per una raccolta dati sleale una concorrenza sleali».

Il principio di equità, responsabilità e trasparenza prevede che queste macchine siano progettate in maniera equa fin dal principio e che si permetta alle persone di comprendere quando, come, dove, in che modo e perché viene usata un’intelligenza artificiale, quali sono gli accorgimenti presi per evitare che l’intelligenza artificiale replichi pregiudizi,

Infine, il principio di innovazione è il più ambizioso, utopistico, radicale e trans-nazionale: Propone un superamento di tutti i confini: nazionali e industriali, dell’ambiente accademico e dei governi, delle etnie e delle nazionalità, dei generi e dell’età, delle convinzioni politiche e religiose; propone un lavoro congiunto per «creare una piattaforma in cui i dati provenienti da ogni campo possano possono essere effettivamente utilizzati senza essere monopolizzati».

Intelligenze Arficiali in Cina

Ad agosto del 2023 la Cina ha proposto 24 linee guida per un regolamento ad interim, cioè provvisorio, delle intelligenze artificiali generative. Il regolamento si trova qui tradotto in inglese. Tutto sommato, è un regolamento molto scarno e fortemente interpretabile e molto più lasco della bozza che si era potuta leggere nel mese di aprile.

Impone alle aziende che lavorano con intelligenze artificiali generative sul territorio cinese un’adesione dei valori del socialismo così come concepito dalla Repubblica Popolare Cinese.

È abbastanza ambiguo sui temi della proprietà intellettuale: «Quando sono coinvolti diritti di proprietà intellettuale», si legge al secondo comma dell’articolo 6 i diritti di proprietà intellettuale di cui godono legittimamente altri non devono essere violati». Tuttavia, non si specifica se il semplice addestramento di una macchina violi diritti di proprietà intellettuale o meno.

Le intelligenze artificiali nel Regno Unito

Dopo un anno e mezzo di lavori, il 6 febbraio del 2024 il Governo del Regno Unito ha pubblicato un resoconto delle attività svolte, che spiega anche l’approccio adottato. Al di là dei toni entusiastici, l’idea di fondo è quella di dare delle regole che favoriscano l’innovazione. Per evitare il rischio che questo suoni come una frase vuota e priva di senso, se non riempita a dovere, c’è un elemento interessante che va evidenziato: il Regno Unito prevede di investire 10 milioni di sterline per formare le persone che fanno parte degli enti regolatori, in modo che possano avere le competenze e l’esperienza necessaria per questo lavoro. Non è una cosa da poco: la formazione di chi supporta i decisori politici (e la formazione stessa dei decisori politici) è un tema quasi mai davvero esplorato.

La visione dei Paesi Bassi

Il governo dei Paesi Bassi ha avviato una serie di lavori che riguardano esplicitamente le intelligenze artificiali generative, diventate «parte integrante della vita quotidiana di molte persone». Le linee guida di questi lavori sono:

1) sicurezza

2) equità

3) benessere e autonomia delle persone

4) sostenibilità e prosperità

La tecnologia come bene comune

Il fatto che i governi, nel mondo, siano al lavoro su questi temi ci racconta un fatto ben preciso: qui non siamo di fronte all’hype marketing del momento. È una cosa che sanno bene le persone che studiano e lavorano alle intelligenze artificiali da anni.

L’approccio più ambizioso, radicale e utopistico, quello che sceglierei personalmente, è quello giapponese. È difficile attuarlo senza un sostegno globale – senza, appunto, quella governance globale di cui parlavamo all’inizio. Tuttavia, è il tipo di approccio di cui abbiamo bisogno, se non altro da un punto di vista di metodo e di visione sul futuro.

È un approccio che, invece di preoccuparsi dei recinti da mettere intorno alla proprietà intellettuale o intorno alle tecnologie le tratta, piuttosto, come un bene comune, cercando di depotenziare lo strapotere di poche aziende e di una manciata di stati (probabilmente dipendenti, comunque, da queste aziende).

Note di trasparenza

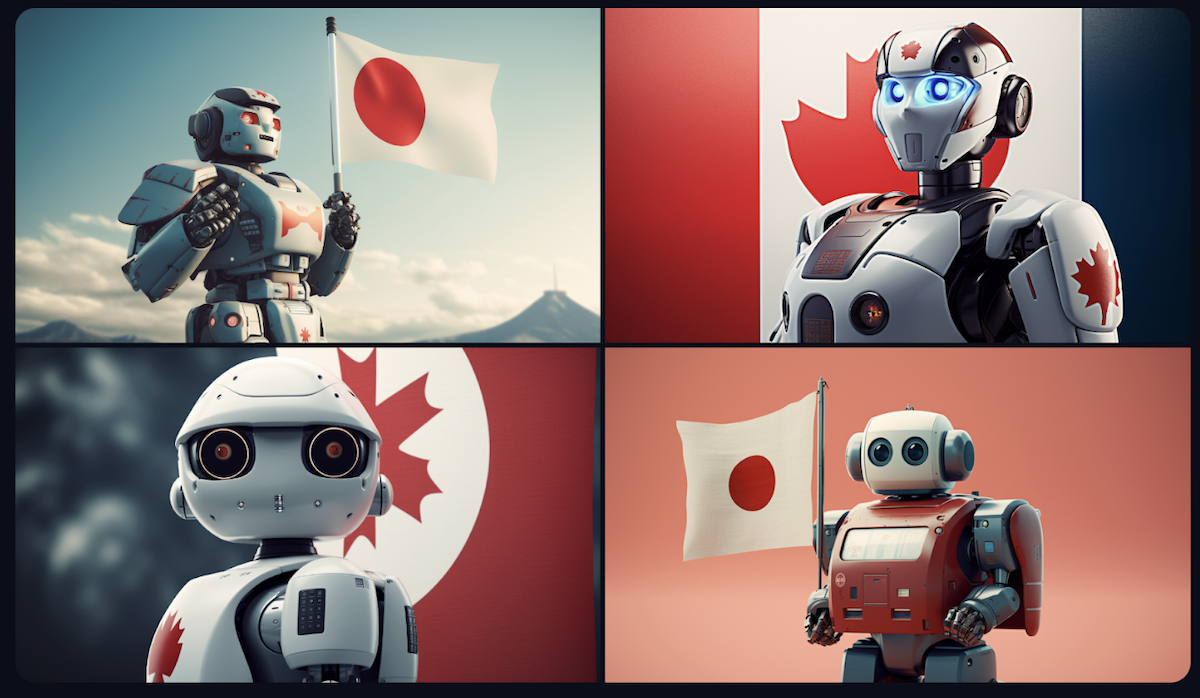

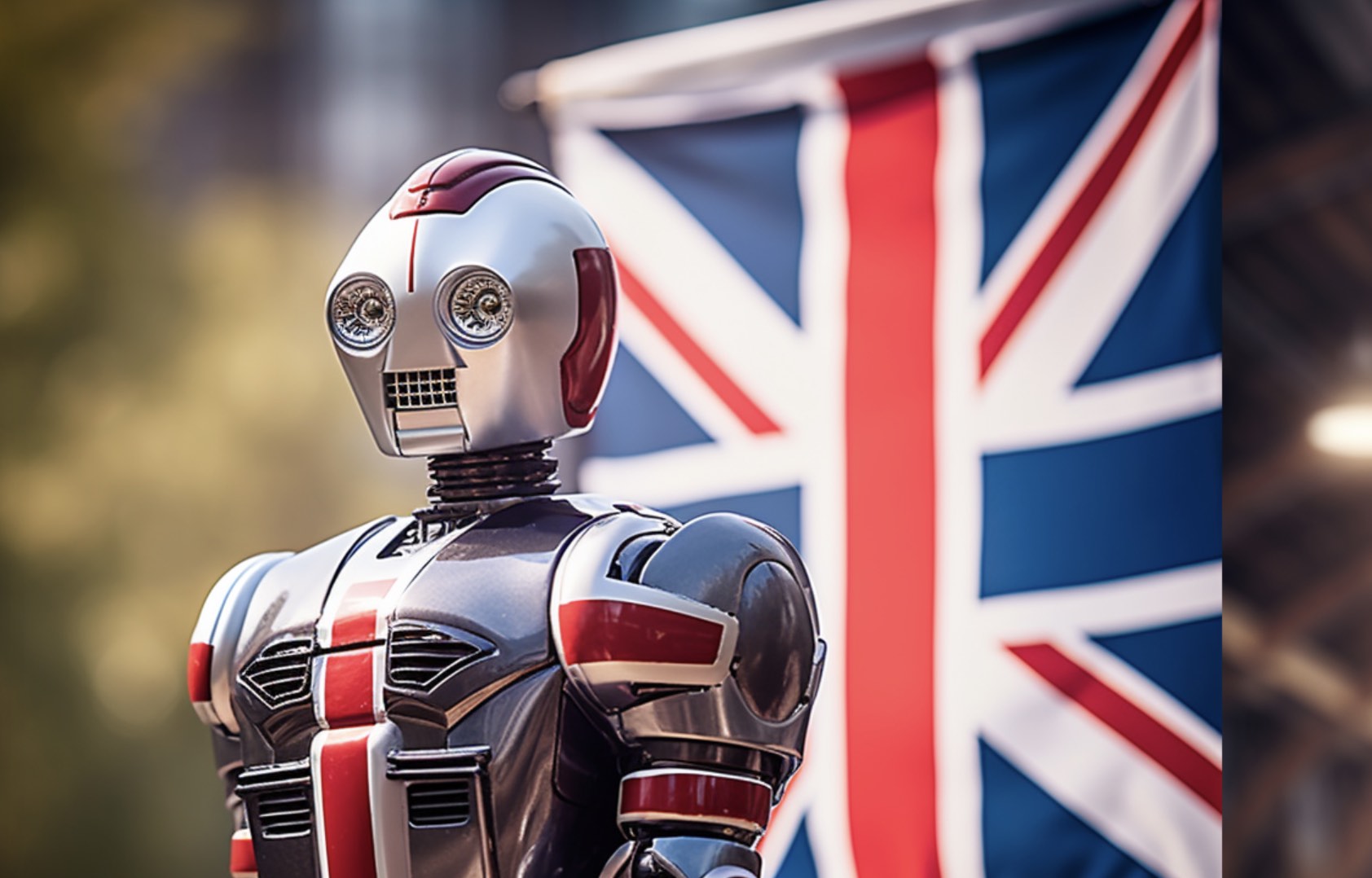

Come faccio spesso, ho usato Midjourney per illustrare questo articolo. A parte l’immagine di copertina, il concept delle illustrazioni è molto semplice. Volevo verificare eventuali bias “nazionalistici” su Midjourney e così ho scritto, per tutte le immagini, un prompt molto semplice: «a robot holding a *** flag –ar 7:4». Ho sostituito agli asterischi la nazionalità che volevo esplorare di volta in volta. –ar 7:4 è il comando che uso per avere una proporzione orizzontale dell’immagine.

Ho utilizzato ChatGPT per la sintesi e la scalettatura di alcuni documenti, fra cui il regolamento cinese e quello giapponese, dopo averli letti in lingua inglese.