Catalog for the Post Human: cosa siamo disposti a cedere per performare meglio?

Quanto siamo disposti a rivelare dei nostri dati sensibili per performare meglio?

Forse è il caso di iniziare a preoccuparci di cosa viene fatto coi dati che forniamo in giro.

Che fare quando gli algoritmi che ci circondano sono opachi? Che fare se non ci viene detto chi userà i nostri dati, né come? Quali sono le alternative?

Siamo circondati da algoritmi, da applicazioni che prendono costantemente i nostri dati, ci profilano, sanno quello che facciamo, cosa ci piace, cosa no, con chi parliamo. Sono processi talmente inseriti nella nostra quotidianità che li reputiamo totalmente normali.

Eppure, raramente sappiamo cosa viene fatto con i dati che forniamo. Raramente ci preoccupiamo di quali siano, che fine facciano, di quando abbiamo prestato il consenso al loro trattamento.

E forse è il caso di iniziare a farlo. Seriamente.

Partiamo dalle basi. Un algoritmo è, sostanzialmente, un insieme finito di istruzioni utilizzato per risolvere un insieme specifico di problemi calcolabili, a partire da uno o più dati di input. Pur non rendendocene conto, abbiamo a che fare ogni giorno con degli algoritmi. I social network li utilizzano per – teoricamente – suggerirci i contenuti maggiormente in linea con i nostri interessi, Google per proporci dei risultati di ricerca in linea con le parole o frasi che cerchiamo (in input).

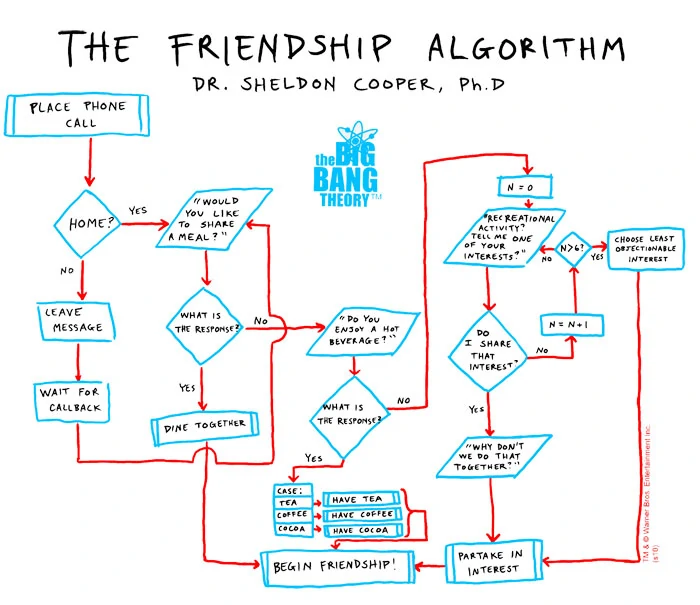

Per capirci, e avere anche un bell’esempio visivo, in un episodio di The Big Bang Theory il Dottor Sheldon Cooper crea un algoritmo che possa aiutarlo a fare amicizia.

Eccolo qui:

Gli algoritmi vengono utilizzati anche per quei processi che vengono chiamati di automated decision-making, o ADM: dei processi che consentono di prendere decisioni in maniera automatizzata senza che sia necessario l’intervento umano.

Banalmente, alcune piattaforme per effettuare test a risposta multipla utilizzano dei sistemi ADM.

Quando si fa il quiz per ottenere il foglio rosa l’esaminando inserisce in input le proprie risposte, ed è la piattaforma a restituire l’esito in output (promosso o bocciato) senza che sia necessario l’intervento di un esaminatore.

Ora, i sistemi di ADM stanno venendo sfruttati in società in maniera sempre più massiccia. In particolare, come ottimamente documentato da Algorithm Watch la pandemia da Covid-19 sembra aver dato alla loro adozione una bella spinta in avanti, nel bene e nel male.

L’esempio più lampante è quello della app Immuni, che tanto ha fatto parlare di sé.

Il funzionamento di Immuni, di per sé, è piuttosto semplice ma lo semplifichiamo ulteriormente all’osso: chiunque lo scarichi e lo tenga attivo si vede assegnare una serie di numeri identificativi, che per ragioni di sicurezza cambiano ogni 15 minuti e che vengono comunicati tramite bluetooth agli utenti nelle vicinanze.

Qualora uno di questi utenti risulti positivo al Coronavirus, e lo segnali all’interno dell’app, gli utenti con cui è stato in contatto vengono avvertiti in modo che possano effettuare un tampone ed eventualmente mettersi in quarantena.

L’adozione di Immuni come app “ufficiale” da parte del Governo italiano ha fatto molto discutere, non tanto per l’iniziativa di per sé, quanto per i problemi che ha fatto emergere riguardo il rapporto tra privacy individuale e sistemi di contact tracing, profilazione e ADM in generale, che molto spesso risultano poco trasparenti.

Il discorso principale non è se sia “giusto” o meno utilizzare Immuni, come sembra essersi polarizzato il dibattito durante gli scorsi mesi, quanto più ampiamente se sia giusto o meno far adottare acriticamente dei sistemi di ADM che nella maggior parte dei casi utilizzano dei dati personali – talvolta senza che sia chiaro quali – in maniera opaca.

Immuni ha solo messo sotto gli occhi di tutti quelle che sono problematiche che normalmente ci facciamo scivolare addosso.

Riflettiamoci: quante volte, per utilizzare un servizio, un’app, un sito web, abbiamo acconsentito ai famosi Termini e Condizioni senza pensarci, senza leggere, senza informarci su ciò a cui stavamo prestando il consenso?

E altrettanto, quanti di questi servizi in ogni caso ci informano chiaramente riguardo quello che faranno con i nostri dati?

E tornando ad Immuni, come si pretende che un’app adottata ufficialmente dal Governo possa riscuotere consenso unanime, se promossa senza tener conto fin da subito delle preoccupazioni (legittime) per la privacy degli utenti, e senza che queste ultime vengano immediatamente calmate con la totale trasparenza riguardo il funzionamento il sistema, derubricando le ansie degli utilizzatori a dei capricci?

E il fatto che in molti abbiano dichiarato che per contenere la pandemia fosse sacrificio giusto e necessario, in ogni caso, sacrificare la privacy dei singoli, non è un precedente pericoloso?

Immuni ci ha fatto solamente rendere conto di quanto il re sia nudo.

Il guaio è che, passata la polemica e la paura del momento, le tematiche sollevate si sono (ancora una volta) spente.

Come documentato nel report 2020 di Automatic Society, in Italia il dibattito pubblico sui sistemi di ADM è acceso, ma con due problematiche principali: la mancanza di una definizione univoca, chiara e formale di “ADM”, e la mancanza, di conseguenza, di norme specifiche sul loro utilizzo.

Eppure vengono usati, e si vogliono usare.

Nel 2016, un sistema di ADM aveva, con tutta una serie di problemi che ne avevano poi causato l’accantonamento, valutato le richieste di mobilità da parte di oltre 200.000 insegnanti.

Alla Scuola superiore Sant’Anna di Pisa si sta sperimentando la cosiddetta giustizia predittiva.

Negli aeroporti di Roma Fiumicino, Milano Linate e Milano Malpensa si sperimenta un sistema di riconoscimento facciale che possa snellire code e controlli, diminuendo al contempo la possibilità che si verifichino errori.

Poco prima della pandemia, si parlava di adottare dei sistemi di riconoscimento facciale e sonoro all’interno degli stadi, per combattere gli episodi di razzismo.

Ora, sia chiaro: gli intenti non sono da condannare di per sé, ma, come accennato, lo è la mancanza di trasparenza riguardante la raccolta dei dati, l’uso che se ne fa, chi sarà a trattarli – spesso aziende private che si aggiudicano un appalto. E infatti il dibattito è aperto anche al Parlamento Europeo, che se da un lato vuole adottare AI e algoritmi al servizio delle persone, e “degni di fiducia”, dall’altro sembra voler spingere soprattutto verso lo sviluppo di tali tecnologie in un’ottica commerciale che ha destato non poche preoccupazioni.

Il rischio principale è continuare a vivere, e vivere sempre di più, in una black box-society: espressione coniata da Frank Pasquale, docente della Brooklyn Law School che profetizza una società fatta di scatole nere, appunto, una serie di algoritmi che governano le nostre vite ma il cui contenuto e funzionamento non è dato conoscere.

È questo quello che vogliamo?

In Europa abbiamo il cosiddetto General Data Protection Regulation, o GDPR: il Regolamento Generale sulla Protezione dei Dati, entrato in vigore nel 2016 e applicabile dal 25 maggio 2018.

Si tratta di un regolamento europeo che disciplina la maniera in cui organizzazioni e aziende trattano i dati personali, tutelando il diritto delle persone ad avere un controllo totale delle informazioni che le riguardano.

In maniera estremamente sintetica, se si forniscono i propri dati personali ad un servizio, un’attività o un’associazione, questi ultimi devono comunicarci con esattezza:

Per consentirci di scegliere se dare o meno il consenso in maniera pienamente consapevole.

Risale al 25 maggio 2021 una sentenza della Corte di Cassazione che ha messo in chiaro, qualora un algoritmo ci profili in maniera automatica con la possibile conseguenza di una limitazione della nostra libertà individuale, che il consenso dato viene considerato valido solamente se lo abbiamo espresso “in riferimento ad un trattamento chiaramente individuato”: se ci è stato spiegato, ovvero, come l’algoritmo funziona. Eppure, il tutto è ancora piuttosto fumoso, tant’è che una simile sentenza tende a “fare notizia”.

Ancora una volta è Algorithm Watch a venirci in aiuto, che nel suo report fornisce alcuni spunti da tenere in considerazione.

In particolare sono necessari:

Sembra banale, ma senza questa prima condizione è impossibile andare oltre.

“Senza la possibilità di sapere come, perché e a quali scopi i sistemi di ADM vengano adottati, tutti gli sforzi per riconciliarli con i diritti fondamentali sono destinati a fallire”.

Occorrerebbe dunque la creazione di registri pubblici per i sistemi di ADM utilizzati nel settore pubblico, in modo che chiunque possa consultarli liberamente e valutarne il funzionamento.

Cosa significa?

Che occorre mettere a punto un sistema univoco che renda possibile verificare e e controllare oggettivamente i sistemi algoritmici: a questo proposito, sarebbe auspicabile la promozione di organizzazioni della società civile – istituzioni accademiche e giornalisti in primis – che fungano da watchdog.

Che è un po’ il nocciolo dell’intera questione.

A che scopo aumentare la trasparenza degli algoritmi usati nella società, se non sappiamo cosa sono o come si leggono? Se il dibattito pubblico sul tema sembra essere congelato, o confinato a pochi addetti ai lavori?

E a che scopo farlo se, quando la questione raggiunge un pubblico ampio, si tende a relegare le preoccupazioni che ne derivano come delle lamentele prive di fondamento?

3 gennaio 2023

Foto – Unsplash

Che fare quando gli algoritmi che ci circondano sono opachi? Che fare se non ci viene detto chi userà i nostri dati, né come? Quali sono le alternative?

Quanto siamo disposti a rivelare dei nostri dati sensibili per performare meglio?

Forse è il caso di iniziare a preoccuparci di cosa viene fatto coi dati che forniamo in giro.

Quanto siamo disposti a rivelare dei nostri dati sensibili per performare meglio?

Oggi tutti, più o meno, siamo sottoposti al riconoscimento facciale. Ma come funziona veramente?

Arte e intelligenza artificiale possono convivere?

I social network ci tengono incollati a sé. Ma come fanno? E perché?

Domande e risposte sul destino della lotta di classe ai tempi delle I.A.

Come stiamo usando le tecnologie per un lavoro sul 2 agosto 1980

Da Sanremo a Magenta, fotografando con un aggeggio strano che converte, inventando, le tue foto rendendole digital-retrò.

Tutto quel che vuoi sapere sulle intelligenze artificiali generative e che puoi chiedere